O conteúdo do seu site só será lido se ele for achado pelas pessoas. Pode ser por rede social ou pesquisa no Google, mas em algum momento alguém teve que buscar o endereço do seu conteúdo.

Essa é a função dos bots da internet. Um dos bots mais famosos, o GoogleBot, é o robô da Google que realiza a indexação de todo o conteúdo da internet. Ele navega pelo seu site lendo todos os textos, salvando todos os links e imagens.

Só que o acesso do bot é muito semelhante ao acesso de um cliente/visitante normal. O servidor do site ainda precisa preparar a página e enviar para o bot.

Bad bots: Robôs malvados

Agora, imagina que um bot muito malvado está realizando milhares de acessos ao seu site, fazendo com que o servidor não consiga mais entregar as páginas para todos os visitantes. Os seus clientes/visitantes vão cansar de esperar e vão acessar o site da concorrência.

Uma das formas de contra-atacar esses bots é usando o plugin Blackhole for Bad Bots.

Esse plugin é muito leve. Ele basicamente adiciona um link invisível no meio do site e bloqueia todo mundo que tentar acessar esse link.

Mas e o GoogleBot?

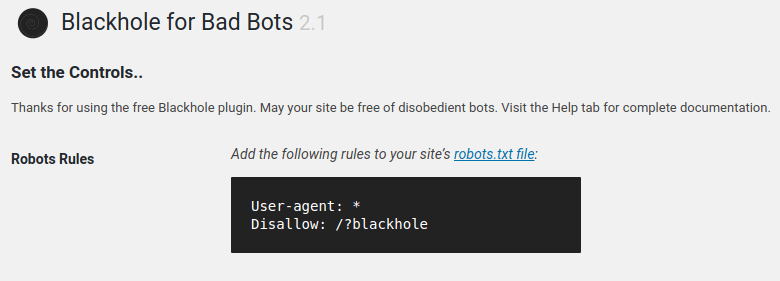

Para deixar o plugin funcionando, você deve adicionar um arquivo chamado robots.txt na raiz do seu site com o seguinte conteúdo:

User-agent: *

Disallow: /?blackholeEsse arquivo explica para os robôs como o site deve ser acessado. Você pode notar que, na segunda linha, tem uma regra: Não entre em /?blackhole

Os “robôs do bem” vão ler esse arquivo e respeitar todas as regras. Sendo assim, quando eles enxergarem o link escondido para /?blackhole vão ignorar e seguir adiante.

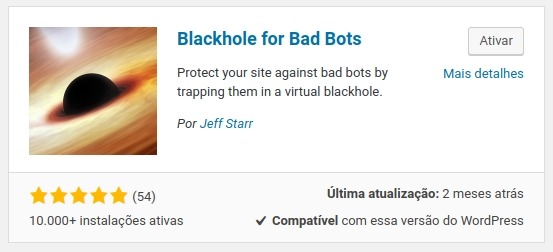

Instalando o Plugin

O plugin está disponível do repositório oficial do WordPress. Faça login no painel do seu site e vá para Plugins > Adicionar Novo

Procure pelo plugin chamado “Blackhole for Bad Bots”. Este é o card dele:

Configurando o Plugin

Após a instalar e ativar, você vai enxergar o menu “Blackhole” na barra lateral. Acesse a opção de Settings/Configurações.

Lá, você terá acesso ao conteúdo que deve inserir no arquivo robots.txt:

Você pode alterar/criar o arquivo robots.txt fazendo acesso FTP/SSH. Se essas siglas foram estranhas para você, então peça para um adulto fazer essa alteração.

Lembre-se: Verifique se o arquivo robots.txt já possui algum texto antes de fazer alteração.

Controlando falsos positivos

Deixe habilitada a opção de alertas por e-mail e acompanhe os IPs que o plugin for bloqueando.

Geralmente, os IPs da China, Cazaquistão e outros país do mesmo naipe são realmente de bots.

Agora, se o plugin bloquear um IP do Brasil verifique se não foi um usuário que, por algum motivo, tentou acessar essa URL. Os servidores do Brasil geralmente bloqueiam os bad bots antes que eles possam fazer algum estrago.